Dixit v39

enero-diciembre 2025

10.22235/d.v39.4376

Artículos de investigación

La agenda de la computación ubicua: genealogía de su olvido y fundamentos de su prospectiva

The Ubiquitous Computing Agenda: Genealogy of Its Oblivion and Foundations for Its Foresight

A agenda da computação ubíqua: genealogia de seu esquecimento e fundamentos de sua prospectiva

Luis Sebastián R. Rossi1 ORCID: 0000-0003-3638-5857

1 Instituto de Estudios Sociales, CONICET - Universidad Nacional de Entre Ríos, Argentina, [email protected]

Resumen:

La diversidad artefactual impide captar el impulso

detrás del cambio tecnológico. El objetivo de este artículo es sistematizar la

agenda de la computación ubicua como vector de esas transformaciones y como

programa de I+D fundamental para comprender las tecnologías mediales actuales.

El método de aproximación deriva del análisis crítico propio de perspectivas

materialistas en estudios de comunicación y medios (arqueología y reconstrucción).

En primer lugar, se abordan dos fases genealógicas de la agenda ingenieril e

industrial: computación móvil, distribuida y con conocimiento de contexto, e

informática invisible, imperceptible y compartida. En segundo término, se

exploran los fundamentos teóricos y epistemológicos de la agenda. En tercer

lugar, se recuperan líneas de investigación derivadas tanto en sistemas

inteligentes como en Internet de las cosas. Este artículo realiza aportes para

comprender el sustrato de uno de los programas de I+D más importantes del

presente. Para ello, recupera su sedimentación histórica, presenta las

conexiones subrepticias con realidades mediales contemporáneas (IoT, Pervasive

AI, etc.) e ilumina los sectores en los que el proyecto de la ubicomp resta

indeterminado e inconcluso. Las conclusiones problematizan el carácter de

olvido que convirtió a la ubicomp en el sustrato detrás del desarrollo

tecnológico presente y de su prospectiva.

Palabras clave: informática; medios de información; diseño de sistemas; Internet; industria de la comunicación.

Abstract:

The diversity of artifacts often obscures the

driving force behind technological change. This article aims to systematize the

agenda of ubiquitous computing both as a vector of these transformations and as

a key R&D program for understanding contemporary media technologies. The

methodological approach is grounded in critical analysis from materialist

perspectives within communication and media studies—specifically,

archaeological and reconstructive methods. The article first examines two

genealogical phases of the engineering and industrial agenda: mobile,

distributed, and context-aware computing; and invisible, imperceptible, and

shared computing. It then explores the theoretical and epistemological

foundations of the agenda. Finally, it reviews research lines that have emerged

from this agenda, particularly in the fields of intelligent systems and the

Internet of Things. This article contributes to understanding the substrate of

one of the most significant R&D programs of our time. It does so by

recovering its historical sedimentation, unveiling its covert connections to

contemporary media realities (IoT, Pervasive AI, etc.), and highlighting the

areas in which the ubiquitous computing project remains indeterminate and

unfinished. The conclusions reflect on the nature of the oblivion that has

rendered ubiquitous computing the hidden substrate of present-day technological

development and its foresight.

Keywords: computer science; information media; systems design; Internet; communication industry.

Resumo:

A diversidade contemporânea de gadgets nos impede

captar o impulso por trás da mudança tecnológica. O objetivo deste artigo é

sistematizar a agenda da computação ubíqua como vetor dessas transformações e

como programa de P&D fundamental para a compreensão das atuais tecnologias

midiáticas. O método de abordagem deriva da análise crítica própria de

perspectivas materialistas em estudos de comunicação e mídia (arqueologia e

reconstrução). Primeiramente, abordam-se duas fases genealógicas da agenda de

engenharia e industrial: computação móvel, distribuída e com conhecimento de

contexto e, informática invisível, imperceptível e compartilhada. Em segundo

lugar, exploram-se os fundamentos teóricos e epistemológicos da agenda. Em

terceiro lugar, recuperam-se linhas de pesquisa derivadas tanto de sistemas

inteligentes quanto da Internet das Coisas. Este artigo contribui para

compreender o substrato de um dos programas de P&D mais importantes da

atualidade. Para isso, recupera sua sedimentação histórica, apresenta as

conexões sub-reptícias com realidades midiáticas contemporâneas (IoT, Pervasive

AI, etc.) e ilumina os setores nos quais o projeto da ubicomp permanece

indeterminado e inconcluso. As conclusões problematizam o caráter de

esquecimento que transformou a ubicomp no substrato por trás do desenvolvimento

tecnológico presente e futuro.

Palavras-chave: informática; meios de informação; design de sistemas; Internet; indústria da comunicação.

Recibido: 28/11/2024

Revisado: 07/05/2025

Aceptado: 12/05/2025

Introducción

Alternativamente comprendida como nuevo paradigma de diseño en informática (computer science) o como era inédita de computadoras concretas, la etiqueta “computación ubicua” (ubiquitous computing, ubicomp, UC) condensa, desde hace más de tres décadas, el horizonte de futuro sobre la dirección del cambio tecnológico. Sea como sistema de pensamiento, método o como tendencias y oleadas de objetos técnicos específicos, este framework —también llamado informática omnipresente (pervasive computing)— ha gestado y reagrupado distintos linajes técnicos que pretenden reestructurar las prácticas y el tejido de la vida cotidiana al devenir parte de nuestros entornos y disolverse en los contextos más íntimos de nuestras actividades.

Las raíces de esta agenda se remontan a las últimas décadas del siglo XX (Greenfield, 2010; Rogers, 2006; Tolmie et al., 2002) y lograría consolidarse —en todas sus variantes y reformulaciones— como uno de los programas de investigación, desarrollo e innovación (I+D+i) cruciales en informática. En efecto, su impulso sigue vigente y se ha fundido en campos decisivos de la prospectiva de centros y laboratorios académicos y corporativos (desde Big Tech hasta startups de software y servicios informáticos). En especial, esta agenda ingenieril tiene como meta integrar, desplegar y hacer coevolucionar tecnologías computacionales sobre todas las ecologías físicas, mentales y sociales. Por este ímpetu no deja de entrelazarse con distintos órdenes de magnitud al querer abarcar, como dirán sus ideólogos, “de los átomos a la cultura” (Weiser et al., 1999, p. 693).

En esos términos, también cifra un desafío —aún no saldado— para las ciencias sociales y las humanidades, de las cuales extraería sus supuestos más originales. Asimismo, si bien el núcleo firme y el cinturón protector del programa constituyen la base para el desarrollo detrás de infraestructuras mediales contemporáneas, paradójicamente, los estudios y teorías de comunicación y medios tampoco han reparado en el carácter central de este framework de diseño tecnológico. De allí que, para cubrir esta vacancia, el objetivo de las siguientes páginas será reconstruir, desde una aproximación materialista, los elementos históricos, los fundamentos y la prospectiva de la ubicomp como pilar del futuro medial. Así, este artículo se apoyará en una aproximación metodológica derivada del análisis crítico al servicio de la reconstrucción genealógica de los aspectos básicos de la agenda de la computación ubicua.

En efecto, las caracterizaciones epistemológicas e históricas de la informática implican, al menos, tres formaciones discursivas que —nacidas de las sucesivas crisis de sistemas— intentan definir la investigación y el desarrollo en el campo (con diferencias metodológicas, ontológicas y epistémicas). En primer lugar, existen formas de comprender a las ciencias de la computación que se derivan de corrientes formalistas y racionalistas (aproximaciones matemáticas y lógicas orientadas al estudio de algoritmos, estructuras de datos, autómatas, modelos, etc.). En segundo término, otras perspectivas la entienden como ciencia (teórica y experimental) caracterizada por el estudio empírico de fenómenos computacionales y maquinales (con técnicas de ciencias exactas y naturales heredadas de la cibernética y de la teoría de sistemas). Por último, la rama más dinámica desde mediados de la década de 1970 la constituyen marcos conceptuales que provienen de la ingeniería y que se dedicarán a explorar los prototipos del futuro medial. Estas aproximaciones se caracterizan por el estudio del diseño tecnológico de sistemas complejos (software/hardware) y por analizar las condiciones de desarrollo, producción, construcción e implementación de productos y servicios escalables en términos industriales, comerciales y sociales (Wegner, 1976; Tedre, 2014; Eden, 2007; Coy, 2001; Angius et al., 2021).

Estas formaciones discursivas a menudo se emparentan con la noción de paradigmas[1] como matrices disciplinares que reúnen técnicas, creencias y valores compartidos en una comunidad científico-tecnológica. En efecto, Michael S. Mahoney (2011) —discípulo de T. Kuhn y lector de I. Lakatos (1983)— rebautiza la concepción convencionalista como agendas de investigación con el fin de pensar el desarrollo de la informática, entendiendo que la transmisión intergeneracional de conocimientos recapitula la historia disciplinar y sirve para reclutar novatos (al estructurar currículos). Así, las agendas de la informática implican consensos, supuestos y prácticas de desarrollo que se asientan en preguntas compartidas, problemas prioritarios, soluciones aceptables, logros alcanzados y predicciones. Pero, particularmente, se caracterizan por una simbiosis constante entre academias y corporaciones que no solo encierra enunciados, sino que se despliega por arquitecturas, infraestructuras y linajes técnicos (Manovich, 2014; Campbell-Kelly et al., 2023; Richterich, 2018; Winograd & Flores, 1989).

Por ello, la noción de agenda que recuperamos no solo tratará de reconstruir los postulados del núcleo duro, sino también las heurísticas que se plasman tanto en hipótesis auxiliares como, fundamentalmente, en desarrollos concretos. En otros términos, cualquier genealogía de una agenda en informática —entendida como vector de medios técnicos que almacenan, procesan y transmiten información— debe detenerse tanto en enunciados como en materialidades (Kittler, 2010; Parikka, 2013).

A la luz de estas aproximaciones, las próximas páginas, en primer lugar, recuperarán —siguiendo las principales contribuciones de los equipos que la impulsaron— los aspectos históricos de la agenda de la ubicomp en dos fases: por un lado, una computación móvil, distribuida y con conocimiento de contexto y, por otro, una informática imperceptible, invisible o calma. Luego volverán sobre los fundamentos filosóficos que configuran, junto a sus diseños y desarrollos efectivos, el núcleo de la agenda. Por último, terminarán con una mirada prospectiva, al comprender las condiciones que hicieron posible que esta agenda se convierta en sentido común de las investigaciones en tecnología de la información.

Historia

Las raíces del concepto de computación ubicua han sido rastreadas a diferentes grupos de trabajo y proyectos del Laboratorio de Ciencias de la Computación de Xerox Palo Alto Research Center (PARC). Si bien los primeros reportes técnicos en utilizar el sintagma datan de finales de la década de 1980 (Weiser et al., 1999; Goodisman, 1991) y no han faltado múltiples anticipaciones,[2] su formulación más citada sería la del director de tecnología (CTO) de la compañía, M. D. Weiser (1991), en un artículo clásico de Scientific American.

En efecto, una primera definición de la computación ubicua dependería de perspectivas en interacción humano-computadora (HCI), pero su alcance pretendía ir más allá. En su configuración habitual implicaría una reestructuración de distintos paradigmas informáticos anteriores que —en un relato lineal— podrían ser definidos como sigue. Primero, una tendencia de informática mainframe —cuyo auge se identifica a mediados del siglo pasado— que involucraba escenarios donde múltiples personas ejecutaban tareas (militares, bancarias, científicas, etc.) en servicios compartidos (time-sharing) caracterizados por ordenadores de gran escala (many to one). En segundo lugar, una tendencia de computadoras personales que, desde mediados de la década de 1970, constituiría relaciones entre un usuario y una máquina para tareas de ofimática y ocio (one to one). En esta interacción primaba la interfaz gráfica de usuario (GUI) bajo la representación intuitiva desktop-WIMP (escritorio, ventana, ícono, ratón, puntero) así como otras tecnologías visuales multimodales derivadas (multimedia, realidad virtual). Para los ideólogos de la agenda ubicomp, las PC tenían como resultado una excesiva atención en pantallas (por ejemplo, ciberespacio) que separaba a las personas del mundo circundante y decantaba en una sobrecarga de información (Weiser et al., 1999; Weiser & Garman, 1995).

Frente a los escenarios de mainframes y PC, la era de la computación ubicua postularía una multiplicación de entidades que computan por cada ser humano (one to many; many to many) y su auge estaba pronosticado para las primeras décadas del siglo XXI. En esos términos, el nuevo framework implicaba multiplicidad de máquinas digitales dispersas en medioambientes físicos y sociales que configurarían tecnologías contextuales y colaborativas imperceptibles para los procesos conscientes (Weiser, 1993a). Procesamiento, análisis, almacenamiento y transmisión de datos serían diseñados para caber naturalmente en la vida cotidiana y en el mundo circundante configurando una “virtualidad corpórea” bajo redes omnipresentes (Weiser, 1991).

Así, en un escenario donde se vaticinaba el apogeo de la ubicomp para el decenio de 2020, la informática mainframe y personal serían reconfiguradas por una tendencia de transición que sería denominada computación generalizada y distribuida y que gestaría infraestructuras nómades de Internet (que hoy llamamos cloud services; Abowd, 2016; Ruparelia, 2016). Esta etapa intermedia constituía, para el grupo de ingenieros que impulsaba la agenda, un nuevo medio con masivos servicios interconectados de información personal, comercial, gubernamental, lúdica, etc. (Weiser, 1996, 1998; Weiser & Brown, 1997).

Como se ve, las premisas desprendidas de esta agenda excederían al campo de la interacción humano-computadora. En particular, implicaban un framework que suponía cambios más profundos en infraestructura informática, en arquitecturas, velocidades y protocolos de redes (wireless), en componentes microelectrónicos, en hardware móvil, en sistemas operativos y de archivos, en middleware, en gestión energética, en periféricos, formatos, sensores y elementos de interacción; en las medidas de seguridad y privacidad, en software y aplicaciones y hasta en la teoría computacional (Weiser, 1992, 1993a). De ese modo, el volumen de los cambios anticipados por la agenda ubicomp necesitaría varias fases de concretización —no cronológicamente distinguibles— cuyas formas más complejas aún restan indeterminadas e inconclusas. En particular, se han diferenciado dos etapas que implicaban métodos de prototipado (y que buscarían inventar el futuro medial con elementos y componentes electrónicos disponibles a inicios de 1990).

Primera fase: computación móvil, distribuida y con conocimiento de contexto

Así, la primera fase del programa ubicomp estaría cifrada por computadoras distribuidas, conectadas y, en algunos casos, móviles y portables de diferentes tamaños: pulgadas (micro), pies (meso) y yardas (macro). Estos tres niveles implicarán desarrollos específicos —con financiamiento gubernamental (DARPA)—. Objetos técnicos que, siguiendo analogías con tecnologías escriturales, se presentaban como etiquetas (ParcTabs), cuadernos (ParcPads) y pizarras (LiveBoards). A estas máquinas se le sumarán insignias (active badges desarrolladas por Olivetti Research y DEC; Want et al., 1992) y tarjetas computacionales (Weiser, 1993a, 1995). Independientemente de los múltiples matices de diseño, el acento de la nueva agenda pasaba por el radical carácter infraestructural, colaborativo y conectivo que impulsaba los procesos computacionales.

En efecto, de los tres desarrollos el más documentado sería el proyecto ParcTabs cuyos orígenes se remontan a 1991, con pruebas piloto en varios países y con objetivos que se centraban en diseñar hardware, arquitecturas y software de computación móvil y de telecomunicaciones (Want et al., 1995). La idea era construir objetos técnicos pequeños (de no más de 10 cm), livianos (215 g), con pantallas táctiles monocromáticas (de tres pulgadas), feedback sonoro, botoneras físicas, lápices de input, procesadores y memorias integradas de bajo consumo (Intel 8051), baterías de larga duración (níquel-cadmio recargables), conectividad inalámbrica a redes Ethernet (por transceptores infrarrojos). Asimismo, las Tabs acelerarían un constructo tecnológico que comenzaría a crecer desde esos años: las aplicaciones (apps) de software. En efecto, estas computadoras móviles contaban con cerca de cuarenta aplicaciones programadas en Modula-3 (como e-mail, calendario, exploradores de archivos, relojes, procesadores de texto, reportes climáticos, reproductores de video gráfico, input textual, etc.).

A menudo, se ha confundido estos diseños con una mera manifestación del parque tecnológico de la década caracterizado por ordenadores de bolsillo (PDA, pocket PC, palmtops). No obstante, contra la idea de que las computadoras deberían convertirse en entidades autónomas que lleven adelante todas nuestras metas (Weiser, 1991, 1992, 1993a), el énfasis conceptual de la agenda ubicomp estaría puesto en el conjunto o las redes técnicas de procesamiento y almacenamiento descentralizado para el cual serían fundamentales la comunicación y el contexto. En efecto, las ParcTabs eran terminales (clientes) de servidores (agentes) distribuidos por el edificio de Xerox PARC con los cuales compartían datos en redes locales para ejecutar software (situado). En especial, las apps estaban pensadas para ser sensibles y adaptables al contexto (según tiempo, lugar, proximidad, affordances, identidad, eventos, etc.) en una infraestructura nómade que operaría detectando, identificando, localizando y manteniendo la trazabilidad de los artefactos (Weiser et al., 1999). Por ello, sería compatible con desarrollos de insignias de identificación (IR) y no tardaría en abrir discusiones éticas sobre la privacidad.

El mismo diseño colaborativo y contextual estaba detrás de los demás proyectos. Las llamadas ParcPads (ScratchPad, XPad y MPad; Weiser & Garman, 1995) tenían tamaño de libro, conectividad y, aunque similares a las actuales tablets (Mel et al., 1988), estaban pensadas para ser utilizadas como “cuadernos borradores” disponibles en cualquier habitación para cualquier persona. Mientras el otro modelo, ya no portable sino colaborativo, eran las Liveboards (Elrod et al., 1992; Weiser, 1992, 1993). Muros y pantallas interactivas que involucrarían centros como el Massachusetts Institute of Technology (MIT) en su desarrollo y que contaban con sistemas operativos adaptados al trabajo grupal a través de funciones de videoconferencias, filminas, pizarrón electrónico, etc. Más allá de los acentos, para finales de la década, Weiser (1998) advertía que los primeros heraldos de la ubicomp en mercados masivos ya eran identificables en las handhelds y, en efecto, Xerox licenciaría múltiples patentes, plataformas y diseños de hardware mobile con modelos de negocio que fueron continuados por otras corporaciones tecnológicas.

Con ello, la primera fase parecía relativamente completa justo cuando la computación móvil se había constituido en un campo y en una industria que no detendría su marcha (y que se plasmaría, años más tarde, en los famosos smartphones). No obstante, esta primera etapa estaba destinada a ser solamente un punto de partida, pero no la meta a largo plazo del programa ubicomp. Sobre todo, porque sería improbable que alcanzara el objetivo máximo de la agenda: invisibilidad óptima (Weiser & Brown, 1997).

Segunda fase: computación calmante, invisible, imperceptible y compartida

Una segunda etapa de la computación ubicua es más oscura en su formulación, en sus invenciones tecnológicas y en la comprensión de sus principios de funcionamiento (Weiser & Brown, 1997). En efecto, no quedó estrictamente ligada a un conjunto de objetos diseñados y, como eco de su nombre, guardó arcanos inexplorados (Rheingold 1994). En especial, la continuación de la agenda se caracteriza por acentuar los aspectos de tecnología invisible, desapercibida, discreta (unobtrusive), evanescente, casual, profunda, calma o calmante (encalming), transparente, tácita, silenciosa, simple, continua (seamless) y en todas partes (everywhere).

La formulación de esta segunda fase lo encuentra a Weiser, por momentos, fuera de Xerox (Tinnell, 2023) y con sus colaboradores integrados en otras empresas. En especial, implica, como señala Greenfield (2010), un desvanecimiento de las distinciones y diferencias entre sistemas y entre escalas (físicas y cibernéticas; Abowd, 2016; Tolmie et al., 2002). En esta definición parece primar la idea de fusión y reformulación de la computación mainframe y personal pues la ubicuidad es anticipada, aunque no resuelta, por el desarrollo mobile:

La tercera ola[3] de la computación es la de la computación ubicua (UC), cuyo punto de cruce con la computación personal será alrededor de 2005-2020. La era UC tendrá un montón de computadoras compartiéndonos a cada uno de nosotros. Algunas de estas computadoras serán centenares a las que podremos acceder en cuestión de minutos de navegación por Internet. Otras estarán incrustadas en paredes, sillas, ropa, interruptores de luz, autos –en todo. La UC se caracteriza fundamentalmente por la conexión informática de cosas en el mundo. Esto tendrá lugar en muchas escalas, incluyendo las microscópicas (Weiser & Brown, 1997, p. 77; traducción propia).

La ambigüedad del acento sobre el compartir (sharing) parece cifrar que el sesgo más humanista —heredado de la jerga de la HCI— pudo haber quedado atrás al momento de conceptualizar la segunda fase de la ubicomp (o, al menos, incluye una reversibilidad más abismal). Como puede verse, la aproximación ha cambiado significativamente en estos anticipos, no solo porque a finales del decenio de 1990 los desarrollos de hardware wireless y los protocolos de WiFi van a impulsar la agenda de forma sostenida (al punto de que tecnologías como IPv6, Multicast o MBone se vuelven tópicos recurrentes; Weiser, 2001; Weiser & Garman, 1995), sino también porque comienza a ser cada vez más evidente un devenir infraestructural de la computación (Campbell-Kelly & Garcia-Swartz, 2007). En ese sentido, las analogías que, en la primera formulación del paradigma, parecían futuristas (Weiser, 1991), se vuelven, en los albores de nuestra centuria, cada vez más concretas ya que las propiedades infraestructurales reactivan el celebérrimo dictum:

Las tecnologías más profundas son aquellas que desaparecen. Se entretejen en la trama (fabric[4]) de la vida cotidiana hasta que se vuelven indistinguibles de ella (Weiser, 1991, p. 94; traducción propia).

Como puede anticiparse, Weiser (1993a) ideaba su programa análogamente a tecnologías que han devenido infraestructuras omnipresentes (como la escritura y la electricidad) cuya naturaleza transmite información al desaparecer de los procesos conscientes. En la lectura comprensiva, en las prácticas escriturales y en otras tecnologías de comunicación simbólica, la interfaz de los signos se esfuma completamente de la atención: se vuelven invisibles, imperceptibles; funcionan en la periferia. De modo similar, para Weiser las tecnologías calmas deberían configurar portadores concretos de información en el mundo pero cuya característica central sea pasar desapercibidas. Por ello, los microprocesadores incrustados y la computación mobile impulsarán la ubicuidad computacional cuando los objetos más comunes (TV, juguetes, electrodomésticos, etc.) existan interconectados (en lo que hoy denominamos smart):

Al final, ubicomp creó un nuevo campo de la Informática que especuló sobre un mundo físico rica e invisiblemente entretejido con sensores, actuadores, displays y elementos computacionales incrustados sin costuras en los objetos cotidianos de nuestras vidas y conectados a través de una red continua. Lo que es realmente alarmante es cuán rápidamente estamos encontrando esta nueva forma de computación manifestarse a nuestro alrededor (Weiser et al., 1999, p. 694; traducción propia).

Uno de los proyectos experimentales que profundizaba la visión de Weiser sería el de construir entornos responsivos. En especial, Elrod et al. (1993) integraban controles computacionales de infraestructura conectiva en sistemas de ventilación, calefacción, aire acondicionado y electricidad (HVAC) para que sean sensibles a la presencia o ausencia de personas y regulen autónomamente su consumo. No obstante, la vastedad de las interconexiones le permitirá a Weiser y Brown (1997) subrayar que el nuevo paradigma computacional no se agotaba solo en conectar cosas, sino que buscaba reunir problemas de ámbitos extremadamente variados que iban desde las finanzas corporativas hasta las tareas escolares más anodinas o, incluso, se plasmaba en experiencias artísticas (Live Wire de Xerox). Porque, en su fundamento, la idea de computación calma implicaría que las personas compartidas por las redes permanezcan serenas y controlen sus actividades sin prestar atención (en contrapartida a la excitación de las PC) a las máquinas entretejidas al contexto; un paso hacia un espacio computacional situado que incluiría elementos y servicios de informática periférica.

Así, en esta segunda etapa, la ubicomp se integraría a objetos comunes de prácticas cotidianas y al flujo contextual de las actividades. Por ello, para Weiser y Garman (1995), antes que computadoras separadas y especializadas, existirían procesos informáticos infraestructuralmente descentralizados, distribuidos, discretos y desapercibidos (unobtrusive). Una informática sin esfuerzo que actuase en órdenes inconscientes. En esa línea, Krumm (2018) anticipa dos sentidos de esta desaparición, por un lado, computadoras invisibles por estar incrustadas (en edificios, muebles, aparatos, etc.) y, por otro, imperceptibles por operar en la periferia de la atención. Esa ubicomp ya no estará cifrada por la interacción con humanos sino que funcionaría como interfaz entre máquinas sin mediación. Es decir, tecnologías que —aun si postuladas al servicio de lo humano— no tendrían a lo humano en su centro y cuyo reflejo, como veremos, parece derivar en el internet de las cosas (Internet of things, IoT).

En efecto, al momento de proponer un modelo para esta desaparición, Weiser plantea una analogía a todas luces extraña si no se comprenden los fundamentos del programa. Pues, en un guiño a los sistemas evolutivos que pueblan la cibernética desde sus inicios, y en particular a los procesos de aprendizaje maquinal (aunque bajo tónica rousseauniana), la informática devendría omnipresente cuando se presente como:

La infancia —una instancia de juegos, una construcción de cimientos, de constante aprendizaje, un poco misteriosa y rápidamente olvidada por los adultos. Nuestras computadoras deberían ser como nuestra infancia —una base invisible que es rápidamente olvidada pero que siempre está con nosotros, y que es utilizada sin esfuerzo durante nuestras vidas (Weiser, 1994a, p. 8; traducción propia).

Fundamentos

En múltiples pasajes Weiser (1991, 1993b, 1994a, 1994b) apunta que los fundamentos —metafísicos y ontológicos— del framework de su “tecnología posmoderna” no solo provienen de la ingeniería, sino que han sido tomados de trabajos teóricos y empíricos de humanidades, artes y ciencias sociales. Estas disciplinas podrían dar sustento al núcleo de la agenda en la medida que abordan lo que caracterizaba como invisible: el contexto y las condiciones del trasfondo cultural. De hecho, Weiser y sus equipos[5] se inspiran —para diagramar la virtualidad corpórea— en vertientes fenomenológicas y hermenéuticas, en reflexiones sobre el conocimiento tácito, en aproximaciones ecológicas a la percepción, en estudios antropológicos y en análisis de psicosociología crítica sobre procesos cognitivos.

En primer término, la referencia más clara a bases filosóficas se encuentra en la idea del ente a-la-mano (Zuhandenheit, ready-to-hand) como útil entrelazado a una práctica. Weiser y sus colaboradores recuperarán este tópico de Ser y Tiempo (de M. Heidegger), sobre todo al evocar el pasaje del martillar como función de un ente comprendido —en el estar en el mundo— bajo una ocupación pragmática (ontológicamente primaria) y no de forma teorética o especulativa (lo a los ojos). En ese sentido, de acuerdo con Brown y Duguid (2000/2017), la visión de la ubicomp buscaba formas de redefinir las relaciones entre personas en situaciones donde la computación devenía transparente a las prácticas y, por ello, la calma se predicaría también del estado mental de los usuarios:

Así como un buen martillo, correctamente equilibrado, “desaparece” en las manos de un/a carpintero/a y le permite a él o a ella concentrarse en el panorama completo, esperamos que las computadoras puedan participar de un acto mágico similar de desaparición (Weiser et al., 1999, p. 695; traducción propia).

La fundamental interconexión de las metas y los materiales con el entorno circundante podría ser atribuida a la inspiración heideggeriana que encuentra resonancias hermenéuticas. Pues, junto a la idea de a-la-mano también se evoca la noción de horizonte en la medida en que implica una fusión de interpretaciones que permiten la comprensión, en este caso, de actividades concretas (en cierto eco con las ideas de Gadamer). Estas recuperaciones resuenan con el diseño ontológico propuesto, unos años antes, por Winograd y Flores (1989) —cuya potencia radicaba en conceptualizar a las computadoras personales como medios lingüísticos de comunicación—.

Asimismo, el fuerte carácter contextual de la condición humana pudo haber entrado en diálogo con las ideas ecológicas y comunicacionales de G. Bateson, que postulaban la inseparabilidad entre organismo y medioambiente. Sin embargo, de acuerdo con Tinnell (2023), Weiser no se detiene solo en el análisis existencial, sino que sus manuscritos prueban una constante relectura no canónica de “La pregunta por la técnica” que lo llevaba a buscar formas computacionales —más allá de la paradoja— no determinables como Ge-stell (Heidegger, 1997). Independientemente de esos elementos biográficos (de los que difícilmente puede encontrarse rastro en las publicaciones del ingeniero aparte de las referencias al habitar, dwell), la inspiración heideggeriana parece un vector que lleva a estas corrientes del diseño computacional a entrar en diálogo con posturas que estaban más allá de las teorías cognitivistas de la década de 1980; de allí también los reiterados desencuentros con el paradigma simbólico de inteligencia artificial (IA).

Entre estas fuentes, en segundo lugar, aparece M. Polanyi (1966/2002) de quien Weiser toma la intuición de saberes que exceden los niveles declarativos explícitos o lo que puede ser formalizado en palabras. De acuerdo con el químico húngaro, poseemos conocimientos implícitos que tienen un rol crucial en el mundo para concebir problemas y soluciones. Así, la información sensorial —que constantemente excede las limitaciones conscientes— configura la dimensión tácita como condición de posibilidad del entendimiento (como sucede, por ejemplo, en los fenómenos de priming). A partir de Polanyi, Weiser (1999) puede diagramar formas de diseño de la ubicomp que le permiten representar al humano como un iceberg que tiene a los pensamientos conscientes —foco de la atención (distal) — solo como punta, mientras la mayor superficie de los procesos memorísticos, perceptuales, cognitivos, etc. funcionan en un orden tácito; como un fondo subconsciente (proximal) que nos permite conectar con la tarea pero al cual solo prestamos atención frente a inconvenientes (por ejemplo, en el manejo de un automóvil los sonidos periféricos del motor solo son relevantes ante un desperfecto mecánico).

En ese primer sentido, utilizamos información perceptual de la periferia para centrarnos en la actividad de forma calma (lo que Weiser —quizás inspirado en la serenidad heideggeriana— definirá como relación coevolutiva entre personas y mundo circundante). Pero también estas tecnologías devendrían calmas en la medida en que empoderarían la periferia y la nutrirían de información y detalles con los que eventualmente se podría conectar de forma consciente. Para Weiser (1998), con la apuesta de la computación calmante, la información devendría más accesible y, paralelamente, el valor de la presencia y la belleza de los ambientes físicos se incrementaría:

Las computadoras ubicuas ayudarán a superar el problema de la sobrecarga de información. Hay más información disponible en la punta de nuestros dedos durante una caminata por el bosque que en cualquier sistema de computación, a pesar de ello las personas encuentran relajantes a las caminatas entre árboles y a las computadoras frustrantes. Máquinas que quepan en el medioambiente humano en lugar de forzar a los humanos a entrar en ellas harán que el uso de la computadora sea tan revitalizador como una caminata en el bosque (Weiser, 1991, p. 104; traducción propia).

En estos insights queda claro que la imposibilidad de conocer completamente la periferia de nuestra actividad es el reflejo de su riqueza. Por ello, será justamente sobre esas fuerzas del mundo material circundante —que nos llevan a actuar— donde se diseminará el parque computacional ubicuo —sin requerir atención consciente, sin poner al ser humano al control—. En ese sentido, la incorporación de las invariantes visuales y de las affordances de la psicología ecológica de la percepción de Gibson (1986) parecen haber configurado una alternativa para problematizar la idea de periferia en sus dimensiones físicas (tal como las conocidas traducciones para la HCI de Gaver (1991) y Norman (1988/1998). No obstante, Weiser y Brown (1997) sostienen que la noción de affordance, aunque poderosa, tiende a describir la superficie de un diseño que no llega demasiado lejos en la periferia (en efecto, los autores parecen reintegrar las dimensiones culturales y topológicas originarias en la idea lewiniana de valencia, Aufforderungscharakter).

Consecuentemente, en tercer término, además de la radicalización de los postulados ecológicos, la noción de periferia sirve para advertir cómo, a través de J. S. Brown, la agenda de la ubicomp se va a nutrir de las discusiones de grupos del Institute for Research on Learning, una usina de pensamiento que buscaba transformar radicalmente las concepciones sobre aprendizaje. Estos cruces no eran extraños porque en Xerox las investigaciones incluían desde la física del estado sólido hasta estudios antropológicos y sociológicos sobre prácticas del trabajo cooperativo asistido por computadora (CSCW, por sus siglas en inglés; Weiser & Garman, 1995; Rheingold, 1994).

Entre esos equipos un pilar fundamental lo constituye la aproximación etnometodológica de L. Suchman (1985). La autora abordaba las dificultades de los usuarios con una de las primeras fotocopiadoras equipadas con microcontroladores embebidos (Xerox 8200) que, al requerir mayor bagaje de conocimientos, complicaban las operaciones de oficina. Para Suchman, antes que planes racionalmente concebidos a priori (como quería el solipsismo de las teorías cognitivistas) eran las acciones compartidas y colaborativas, las interacciones, conversaciones e intercambios —entre legos y expertos— las que soportaban la operación tecnológica emergente de la configuración social de la situación. Por ello, estas mediaciones del contexto no podían ser sustituidas a través de HCI (definida por sus procesos asimétricos) y solo se hacían legibles a partir de una descripción profunda (en consonancia con la interpretación de H. Dreyfus (1990), sobre el readiness-to-hand heideggeriano).

Siguiendo esa línea, Weiser (1992) y Brown tomarán categorías de J. Lave y E. Wenger (1991) quienes —inspirados en la tradición de la teoría sociohistórica y cultural para criticar al racionalismo— estudiarán los procesos cognitivos como dependientes de las interacciones, de la comunicación y de la comprensión en aprendizajes situados y compartidos (apprenticeship) que configuran una participación periférica legítima en comunidades de practicantes (Weiser y Brown, 1997). Por ello, Lave y Wenger (1991) localizan los procesos de aprendizaje como el acceso creciente de aprendices a roles de participación en actividades ejecutadas por maestros y expertos. Estas transiciones de la periferia de la actividad, al estar involucrados en toda la estructura y en su flujo (full participation), demuestran que los procesos de aprendizaje suceden en acción y configuran una “parte integral generativa de la práctica social en el mundo vivido” (Lave & Wenger, 1991, p. 35; traducción propia).

En especial, estas contribuciones antropológicas —básicas en las tesis sobre cogniciones distribuidas, corpóreas, extendidas e incrustadas de la década de 1990— conforman el núcleo de la noción de periferia en su dinámica de práctica sociocultural de aprendizaje en la que los procesos tecnológicos pueden fluir sin interrupciones. En ese sentido, Weiser y sus colaboradores pueden afirmar que no hay una oposición entre centro y periferia, sino que esta última implica múltiples y variadas formas de estar localizados en campos de participación definidos en una comunidad. De hecho, el ingeniero traducirá estos términos a su esquema —e incluso los relaciona (Weiser, 1991) con la noción cognitivista de compilación en H. Simon—, en la medida en que permiten, por un lado, postular a la ubicomp como “computación situada” (Weiser, 1992) y, por otro, intentar llevar los procesos computacionales tanto al contexto físico como al sociocultural bajo la siguiente pregunta (que busca exceder la interacción y se detiene en el habitar en el mundo):

¿Cómo las computadoras (están) incrustadas en el complejo marco social de la actividad cotidiana, y cómo (interactúan) con el resto de nuestro medioambiente físico densamente entretejido (también conocido como mundo real)? (Weiser et al., 1999, p. 693; traducción propia).

Todos estos fundamentos coadyuvaron en una perspectiva de diseño que comprende que las personas trabajan en un mundo de situaciones compartidas y de habilidades tecnológicas no completamente examinadas; una computación cultural, social e históricamente incrustada (Sengers et al., 2004). En efecto, según Weiser el programa de la ubicomp intentó explicar que los problemas de ingeniería están mal enfocados si se piensa que los límites entre personas y el mundo circundante son simples, observables y solucionables mediante una interfaz estática. Al contrario, la verdadera interfaz excedería la pantalla; estaría cerca del habitar cuya complejidad asomaría cuando las computadoras se vuelvan objetos cotidianos concebidos como “zarcillos” en las enredaderas de contextos, personas y actividades que configuran mundos circundantes (y que solo artificialmente pueden ser interrumpidos por artefactos). Por ello, la agenda de la informática omnipresente intentará “expresar el sentimiento de que necesitaremos construir sistemas de computadoras del futuro que sean tan desordenados y complicados y complejos como nuestras interacciones reales en el mundo” (Weiser, 1999, p. 357; traducción propia).

En ese sentido, el framework de la ubicomp implicará la ambigüedad, la fragilidad, la inestabilidad y la heterogeneidad propias de interacciones entretejidas (Krumm, 2018). No se trata de un emplazamiento uniforme, aunque regulariza y regula prácticas cotidianas. No es idéntica en todos los espacios y medios físicos y psicosociales en los que se despliega y los cuales forma en el mismo movimiento de dispersión. Muta en tanto adquiere la densidad y complejidad de la vida cotidiana y hace evidente que los diseños tecnológicos están sujetos a reformulaciones, a renegociaciones, a inconvenientes, a fricciones, pero también, como subrayan Brown y Duguid (2000/2017), pueden reestructurar los medios psicosociales que integran.

Prospectiva

La agenda de la computación ubicua encontrará continuaciones diferentes que en algunos casos respetarán los principios y objetivos de sus fundadores y, en otros, los transformarán radicalmente. Como anticipamos, el alcance del artículo seminal de Weiser (1991) fue muy amplio, en tanto sería publicado en una de las revistas de divulgación científica más antiguas e importantes de Estados Unidos. Ello explica la atención que logrará en el contexto norteamericano (como el temprano interés de B. Gates) y a nivel mundial, pues distintos proyectos (académicos, comerciales y mediáticos) comenzarían a basarse en el framework de ubicuidad computacional (Weiser, 1993a). En efecto, como señala Abowd (2020), la visión de Weiser inspiraría a varias generaciones de investigadoras/es en computación móvil y distribuida así como en medioambientes inteligentes (incluso si nociones como distributed systems son anteriores, Enslow, 1978). Pero también ampliaría los horizontes de la industria de tecnologías de la información, impulsaría programas gubernamentales y marcaría el paso de la prospectiva a través de varias líneas de patentes y de propiedad intelectual (Rogers, 2006; Ronzani, 2009).

En efecto, una de las mayores reinterpretaciones de la ubicomp se daría en diferentes proyectos y consorcios de investigación del MIT Media Lab durante la década de 1990. En especial, el bestseller de su director será motivo de controversia justamente porque integrará el devenir “smart ready” (inteligentes, quizás también mordaces) de todos los objetos técnicos y de todos los medioambientes con las ideas rectoras de multimedios (con televisores y teléfonos como ejemplos) y de agentes de interfaz basados en IA (para una era posinformacional constituida por metadatos que permitirían perfilar e individualizar a sus asistidos). En la prosa aventurada de Negroponte (1998):

Las habitaciones del futuro sabrán que usted se acaba de sentar a la mesa para comer, que se ha ido a dormir, que acaba de meterse bajo la ducha o que llevó a pasear al perro. En todos estos casos, se evitaría, por ejemplo, que el teléfono sonara. Si usted no está en la casa, no sonará porque usted no está. Y si usted está en la casa y su mayordomo digital decide conectarlo, el picaporte más próximo le podrá decir “perdóneme, señora” y establecer la conexión. (…) Hay quienes llaman a esto “computación omnipresente” y, en efecto, lo es. Pero, esa misma gente, lo presenta como si fuese lo opuesto al uso de agentes interfaz, cosa que, por cierto no es. Los dos conceptos son exactamente lo mismo. (…) La omnipresencia de la computadora personal en la vivienda, será impulsada por los diversos procesos de computación, desconectados entre sí, que hoy en día están en nuestra vida cotidiana (sistemas de reserva aérea, datos sobre puntos de venta, utilización de servicios en línea, mediciones, mensajería, etc.). Todos estos procesos estarán cada vez más interconectados (p. 213).

En su lengua original “computación omnipresente” es ubiquitous computing y esa “gente” es Weiser (1992, 1993a, 1994a) quien era muy contrario a estas interpretaciones y lo manifestaría en distintas charlas. En efecto, el CTO de Xerox apuntará que la imperceptibilidad y desaparición de la ubicuidad no se logra ni en el multimedia, ni en los televisores inteligentes, ni con la realidad virtual —todos tópicos sobre los que el director del MIT Media Lab construye su prospectiva (Xerox Palo Alto Research Center, s.f.)—. Especialmente, dichos paradigmas de interacción ponían el foco absoluto en la atención de las interfaces antes que en su desaparición y dejaban el mundo “real” de lado. Idénticas críticas le valdrán los comandos por voz o los agentes inteligentes y asistentes personales (como el “mayordomo” respetuoso que aprendía de sus usuarios). Al contrario, para Weiser (1992) la ubicomp tenía que buscar integrar y aumentar el mundo físico y social cotidiano que habitamos y, al mismo tiempo, debería dejar de lado metáforas de jerarquía, poder o dominio (como las del “sirviente” o la del “esclavo” perfecto).

No obstante, independientemente de las rencillas, las genealogías no tardarían en identificar el solapamiento de las líneas de agentes inteligentes del MIT y de otros proyectos de IA situada con la informática omnipresente (Wooldridge, 2021). En efecto, esa será la dirección que exploran J.S. Brown y P. Duguid (2000/2017, p. 40) cuando analizan, desde el diseño, el carácter situado de los agentes de IA que, en una clara alusión a Weiser, se “entretejen en el tejido de la vida humana y todas sus complejidades” (traducción propia). De allí que la literatura sobre sistemas multi-agentes inteligentes suponga, ya en nuestro siglo, a la agenda ubicomp como estructura fundamental para su despliegue (Wooldridge, 2009; Milner, 2006).

Asimismo, a inicios de la década de 2000 se terminarían de establecer los cimientos para las tecnologías conectivas e incrustadas en el background de la vida cotidiana y en contextos de producción y comercialización que hoy se llaman Internet of Things y wearable computing (Krumm, 2018). Como vimos, la noción de computación calma quedará indeterminada, pero alentará la gestación de ecosistemas digitales con inteligencia artificial. Esto puede seguirse en múltiples proyectos como Auto-ID (Sarma et al., 1999), Things That Think —también del MIT Media Lab[6] (Ishii & Ullmer, 1997) — y otros que se derivarían de aquellas ideas; incluso si trataban de exceder el “evangelio de la computación ubicua” (Hawley et al., 1997, p. 13; traducción propia) y buscaban privilegiar las cosas “más humildes” (léase orientadas al mercado smart, a la manufactura inteligente, a chips incrustados y a sistemas RFID). En todo caso, la IoT —como visión en la que los seres humanos pasan a ser entradas secundarias de datos y los objetos del mundo físico devienen el principal input de información para una Internet no-humana— será deudora de la orientación hacia la distribución evanescente de la computación —así como también lo será su formato de confederación de estándares y protocolos, por el momento, heterogéneos e incompatibles— (Ashton, 2009; Greengard, 2021; Ali et al., 2023; Atzori et al., 2010).

Como resumen Gubbi et al. (2013), el desarrollo de tecnología microelectrónica (MEMS) y la comunicación wireless impulsaron capacidades para detectar, computar y comunicar en cortas distancias y con ello indujeron parte de lo que constituía el horizonte de la visión general de la ubicomp que incluía diseñar una infraestructura nómade (ahora llamada cloud computing como vía de datificación, servitización, cultura algorítmica, etc.). En el mismo sentido deben interpretarse los trabajos del Ubiquitous Networking Laboratory del Yokosuka Research Park Inc. donde las/os investigadoras/es del proyecto TRON, activo desde 2002, trazan la continuidad entre ubicomp, IoT y edge computing para arquitecturas de smart cities (línea que también podría seguirse en los smart rooms y homes; Al-Fuqaha et al., 2015; Sakamura, 2003; YRP Ubiquitous Networking Laboratory, s.f.).

Más allá de la IoT, para Abowd (2016, 2020) la ubicomp incluso es la fuente de inspiración que permite pensar en la evolución hacia muchedumbres computables (crowd computing) que borran la distinción entre lo humano y lo maquinal así como hacia una envoltura cambiante (shroud computing) que atraviesa estratos orgánicos, inorgánicos y culturales. De hecho, sus fundamentos permitirían estimar una internet de los materiales (IoM) que intentaría que las materialidades de la vida cotidiana tengan conectividad (algo que no parece tan descabellado si tenemos en cuenta que Weiser y Garman (1995) anticipaban la exploración de nanotecnologías).

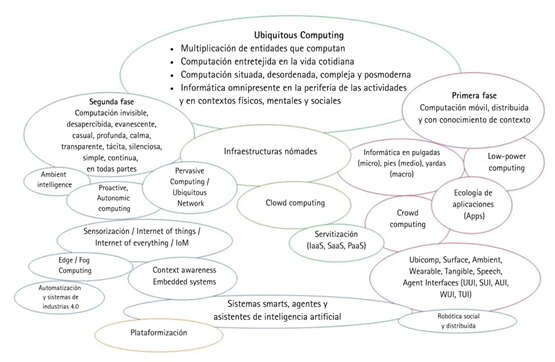

Con el cambio de siglo, el redireccionamiento de Xerox PARC y la muerte prematura de Weiser, el programa transmuta pero seguirá siendo la base para la emergencia de múltiples ensayos orientados al mercado y a la industria del software/hardware. En efecto, parte de los grupos asociados a la ubicomp terminan en instituciones académicas (más allá del MIT y de la Universidad de Tokio como UC Berkeley, Georgia Tech, Cambridge y otras europeas) o son absorbidos en las divisiones de I+D+i de corporaciones tecnológicas (como Intel, Philips, IBM, HP, Google, Microsoft, Apple, etc.). Esto produce dos situaciones, por un lado, se multiplican las denominaciones (Figura 1) que siguen profundizando la agenda —con la consiguiente proliferación de estándares— y, por otro, habrá un rápido olvido de sus antecedentes y fundamentos (aun cuando su nombre se repita; Campbell-Kelly et al., 2023). En efecto, podríamos pensar que si estos programas tienen núcleos que permiten prototipar el futuro medial, sus despliegues concretos impulsan diseños tecnológicos que construyen mundos antes que solo explicarlos. Por ello, podría evocarse la tesis favorita de Lakatos (1983) para recordar con Greenfield (2010) que pocos de los que trabajan en la agenda de la ubicomp serán conscientes de esa pertenencia (en la medida en que sostienen su vigencia elaborando problemas, proyecciones y soluciones del campo). Paralelamente, las manifestaciones múltiples de la agenda la hacen fundamentalmente variable en los contextos culturales en los que se inserta y transforma.

Figura 1: Agenda de la computación ubicua: principales fases y desarrollos

Como ejemplos podríamos tomar cuatro casos de cambios nominales pero de continuidades y variaciones sobre el linaje técnico.[7] En primer lugar, Intel desarrollaría una tendencia propia llamada computación proactiva, que acentuaba el conocimiento del contexto (context awareness) con machine learning y personalización de experiencias digitales (Dourish & Bell, 2011). De hecho, sus raíces pueden ser rastreadas hasta la idea de invisibilidad en Weiser pero explicitando, tal como lo presenta Tennenhouse (2000), un llamado a gestar medioambientes interconectados que deberían desplazar al humano del feedback loop. En efecto, con la mediación de R. Want, desde inicios de nuestra centuria, Intel redireccionaría su agenda para profundizar el alcance de la ubicuidad en las redes de computadoras embebidas que delegarían el control a sistemas de inteligencia artificial (Want et al., 2003). Muchos de estos aspectos, tal como puede leerse en sus más recientes reportes anuales, siguen configurando la base de los modelos de negocio (Intel Corporation, 2023).

En segundo lugar, desde mediados de la década de 1990, también funcionaría la línea de investigación de IBM en Mobile and Pervasive Computing (y, en algunos casos, autonomic computing) que pretendía unir sistemas móviles con servicios financieros y bancarios y con aplicaciones intuitivas para la resolución de tareas diarias basadas en conexiones en todo lugar y en cualquier momento (Hansmann et al., 2001/2013; Saha & Mukherjee, 2003; Ronzani, 2009). El término además quedaría asociado a otras compañías en proyectos y patentes tanto de HP (Barton & Kindberg, 2001) como de Sun Microsystems y Microsoft Research. En tercer lugar, también desde inicios de nuestro siglo y concretamente bajo el impulso de antiguos integrantes de Xerox PARC como Eric Schmidt, Google profundizaría la expansión del programa de la ubicomp. Como lo demostraría, sin ambages, la intervención programática del ex-CEO de la compañía de Mountain View en el Foro Económico de Davos de 2015 donde reeditaría muchos de los tópicos mencionados con marcado acento neoliberal: “Internet desaparecerá” (World Economic Forum, 2015, p. 12).

Por último, otro de los habituales nombres que prolongarían la vida de la agenda será el de ambient intelligence, que sería la versión adoptada desde 1999 por grupos especializados de la Unión Europea, bajo Philips Research (en colaboración con el Oxygen Project del MIT) y con réplicas en Nokia, Siemens y la Fraunhofer-Gesellschaft (Brey, 2005; De Ruyter & Aarts, 2004). Esta continuación de la ubicomp comenzaría a reunir sus principios con interfaces adaptativas y sociales basadas en IA (lo que configuraría avances sobre el perfilamiento o personalización de patrones comportamentales y la sensibilidad al contexto en medioambientes invisibles, proactivos y responsivos).

Se podría observar sin dificultad cómo estas investigaciones corporativas se funden también con tópicos de publicaciones académicas. Podría tomarse, por ejemplo, la revista Pervasive Computing que, editada desde 2002 por el Institute of Electrical and Electronics Engineers (IEEE), tendrá por objetivo repensar, reordenar y dar nuevo nacimiento, marco operante y catálisis a los aportes de Weiser (Satyanarayanan, 2002). La otra fuente de discusiones importantes serán los congresos internacionales como Ubiquitous Computing sostenido desde 1999 por la Association for Computing Machinery (ACM) y la Gesellschaft für Informatik. Siguiendo una línea similar, la ITU (International Telecommunication Union, 2005) impulsaría el desarrollo de IoT a partir del primer lustro de nuestra centuria. Este amplio alcance no es extraño si tenemos en cuenta que, por ejemplo, en el contexto latinoamericano, E. H. Lauría (1992/2000) identificaría la ubicomp con el futuro cercano para la computación móvil y advertiría sobre sus consecuencias para compañías de software vernáculas.

Por último, como sistematizamos en otras oportunidades (Rossi, 2020), las pretensiones de volver computables todos los tejidos físicos, mentales y sociales traerían aparejadas discusiones éticas, culturales y políticas que son revividas de tanto en tanto. Notablemente, las primeras reacciones pueden encuadrarse en las disputas sobre la privacidad y los potenciales peligros de la vigilancia ligadas al context awareness (como active badges; Doheny-Farina, 1994; Anderson, 1991). En distintas oportunidades Weiser (1994, 1995, 1998, 1999; Weiser et al., 1999) señala que, antes que un problema de privacidad, se trata de uno de control, porque es difícil saber quién está gestionando el sistema cuando se vuelve invisible y se esfuma la trazabilidad del flujo de información. Por ello subraya como principios éticos que si se desarrolla tecnología socialmente peligrosa debe ser construida con el mayor grado de seguridad y de salvaguardas posibles (manteniendo la simplicidad para desactivarlas) y, al mismo tiempo, se deberá contarle a todo el mundo que se avanza en esa dirección (ello incluía a científicos sociales y filósofos de PARC que comenzaban a cuestionar dichas tecnologías).

Estos escenarios polémicos —que van más allá de las discusiones de diseño sobre impactos, adopción, adaptabilidad y aplicaciones en sectores y nichos de mercado— permiten advertir que la nueva agenda se convertirá en blanco de críticas culturales sobre múltiples aspectos como los ligados a la responsabilidad moral y legal, los potenciales daños a la autonomía, a la autodeterminación, los crecientes paternalismos tecnológicos, los estereotipos de género y las desigualdades exacerbadas en la tecnología smart, las limitadas capacidades de rendición de cuentas y transparencia; el carácter potencialmente totalitario o el flujo acelerado de datos sensibles hacia intereses corporativos y monopólicos, etc. (Rossi, 2020). Pero Weiser (1991) también anticipaba que conflictos sociales y comunicacionales (como la sobrecarga de información o la adicción a las pantallas) podrían solucionarse en una computación calmante orientada a la periferia. En la misma línea parece haberse dirigido la vasta repercusión mediática de la agenda (como en Wired), pues ya a inicios de siglo un filósofo como L. Winner (2000) se mostraba asombrado de que mecas ingenieriles (como MIT o PARC) se ocuparan de “inútiles” gadgets que pretendían eliminar la complejidad de la vida cotidiana sumando máquinas inteligentes al entorno.

Conclusiones

Weiser pretendía gestar tecnología invisible pero lo que devino transparente fueron los fundamentos, el alcance y las fuerzas de la agenda de la ubicomp. Incluso líneas de desarrollo que se desprenderían de ella y la diversificarían, a veces, serían presentadas como creaciones ex nihilo. Estas bifurcaciones y reformulaciones, propias de las variaciones mediales, podrían explicarse por las dilaciones en el desarrollo de estándares, protocolos y plataformas que, solo en la segunda década nuestro siglo, comenzarían a convertir a la informática omnipresente en infraestructura continua del presente. Quizás el efecto de estas rupturas pudo haber llevado al agotamiento de la denominación.

No obstante, luego de décadas de crecimiento, los enunciados y las materialidades que la ubicomp entrelazaba se volvieron paradigmáticos al punto de conformar una suerte de supuesto detrás de datos, algoritmos y direcciones que tejen la trama de la vida cotidiana. Tal es el sentido con el que hay que interpretar el ingente volumen de manuales, libros de textos y artículos especializados que —trazando explícitamente la sinonimia entre ubiquitous y pervasive computing— borraron todas sus conexiones históricas. Gracias a ello, las ideas más controvertidas de la agenda e incluso sus fundamentos filosóficos y humanísticos tienden a ser olvidados. Sin embargo, comprender los alcances de este programa podría realinear múltiples fenómenos de los estudios de comunicación y medios cuyos desarrollos —luego de tres decenios de estandarización— tienen claros puntos de contacto. En otros términos, una aproximación materialista permite comprender la importancia de la ubicomp para los procesos de cómputo intensivo de macrodatos y para la proliferación de arquitecturas algorítmicas que garantizan la dispersión de la informática en todo el cuerpo social y sobre todas las superficies culturales (tal como es recurrentemente trabajado en relación con procesos como plataformización, datificación, servitización, etc.).

Asimismo, la indeterminación del horizonte del cambio tecnológico y las múltiples interpretaciones de construcción concreta que ha tenido la noción de ubicomp —como agenda y como génesis de objetos técnicos— impiden hacerla un artículo de museo. En ese sentido, sus ramificaciones son tan parte de nuestro presente como vectores trazados sobre el futuro medial. En particular, conocer su horizonte nos permite volver arqueológicamente a los cimientos de medios y linajes técnicos actuales, pero también nos revela las distancias entre los proyectos y sus efectivas concretizaciones. En un futuro medial aún por construir —donde sistemas, agentes y ambientes inteligentes (Pervasive AI) todavía forman la capa novedosa del presente, donde Internet de las cosas prescribe una infraestructura cada vez más actual o donde la computación móvil parece reestructurar todas las actividades cotidianas— se impone la pregunta por las líneas genealógicas que definen nuestra prospectiva.

Como señala Greenfield (2010), la multiplicación de entidades que computan transforma lo que somos, nuestras relaciones con los demás y nuestro mundo circundante. Por ello, la agenda de la ubicomp no ha quedado exenta de controversias ya que (aunque fue pensada desde condiciones humanistas), pudo abrir un espacio de diseño que excede a la forma hombre y despliega vías computacionales sobre todas las ecologías físicas, mentales y sociales. Así, un programa que aspira a transformar y regularizar todas las prácticas socioculturales habilitará ser problematizado, en otras aproximaciones, como tecnología o diagrama que anuda relaciones de poder, formaciones de saber y modos de subjetivación en el capitalismo contemporáneo.

Referencias

Abowd, G. D. (2016). Beyond Weiser: From ubiquitous to collective computing. Computer, 49(1), 17-23. https://doi.org/10.1109/MC.2016.22

Abowd, G. D. (2020). The Internet of Materials: A vision for computational materials. IEEE Pervasive Computing, 19(2), 56-62. https://doi.org/10.1109/MPRV.2020.2982475

Al-Fuqaha, A., Guizani, M., Mohammadi, M., Aledhari, M., & Ayyash, M. (2015). Internet of things: A survey on enabling technologies, protocols, and applications. IEEE communications surveys & tutorials, 17(4), 2347-2376. https://doi.org/10.1109/COMST.2015.2444095

Ali, J., Zafar, M. H., Hewage, C., Hassan, S.R., & Asif, R. (2023). The Advents of Ubiquitous Computing in the Development of Smart Cities - A Review on the Internet of Things (IoT). Electronics 2023, 12, 1032. https://doi.org/10.3390/ electronics12041032

Anderson, B. (1991). The ethics of research into invasive technologies. Rank Xerox EuroPARC.

Angius, N., Primiero, G., & Turner, R. (2021). The philosophy of computer science. https://plato.stanford.edu/entries/computer-science/

Ashton, K. (2009). That ‘internet of things’ thing. RFID journal, 22(7), 97-114.

Atzori, L., Iera, A., & Morabito, G. (2010). The internet of things: A survey. Computer networks, 54(15), 2787-2805. https://doi.org/10.1016/j.comnet.2010.05.010

Barton, J., & Kindberg, T. (2001). The challenges and opportunities of integrating the physical world and networked systems (Technical Report HPL-2001-18). HP Laboratories Palo Alto.

Brey, P. (2005). Freedom and privacy in ambient intelligence. Ethics and Information Technology, 7, 157-166. https://doi.org/10.1007/s10676-006-0005-3

Brown, J. S., & Duguid, P. (2017). The social life of information (2.ª ed.). Harvard Business Press. (Originalmente publicado en 2000)

Campbell-Kelly, M., & Garcia-Swartz, D. (2007). From products to services: The software industry in the internet era. Business History Review, 81(4), 735-764. https://doi.org/10.2307/25097422

Campbell-Kelly, M., Aspray, W., Yost, J., Tinn, H., & Díaz, G. C. (2023). Computer: A history of the information machine. Routledge.

Coy, W. (2001). Was ist Informatik? Zur Entstehung des Faches an den deutschen Universitäten. En J. Desel (Ed.), Das ist Informatik (pp. 1-22). Springer. https://doi.org/10.1007/978-3-642-56774-2_1

De Ruyter, B., & Aarts, E. (2004). Ambient intelligence: visualizing the future. AVI’04 Proceedings of the working conference on Advanced visual interfaces, 203-208. https://doi.org/10.1145/989863.989897

Doheny-Farina, S. (1994). The last link: Default = Offline, or why ubicomp scares me. Computer-mediated Communication, 1(6), 18-20.

Dourish, P., & Bell, G. (2011). Divining a digital future. MIT Press.

Dreyfus, H. (1990). Being-in-the-world (Vol. 1). MIT Press.

Eden, A. H. (2007). Three paradigms of computer science. Minds and machines, 17, 135-167. https://doi.org/10.1007/s11023-007-9060-8

Elrod, S., Bruce, R., Gold, R., Goldberg, D., Halasz, F. G., Janssen, W. C., Lee, D., McCall, K., Pedersen, E., Pier, K. A., Tang, J., & Welch, B. B. (1992). Liveboard: a large interactive display supporting group meetings, presentations, and remote collaboration. CHI '92: Proceedings of the SIGCHI Conference on Human Factors in Computing Systems, 599-607. https://doi.org/10.1145/142750.143052

Elrod, S., Hall, G., Costanza, R., Dixon, M., & Des Rivieres, J. (1993). Responsive office environments. Communications of the ACM, 36(7), 84-85. https://doi.org/10.1145/159544.159626

Enslow, P. H. (1978). What is a “distributed" data processing system? Computer, 11(1), 13-21. https://doi.org/10.1109/C-M.1978.217901

Gaver, W. (1991). Technology affordances. CHI '91: Proceedings of the SIGCHI conference on Human factors in computing systems, 79-84. https://doi.org/10.1145/108844.108856

Gibson, J. J. (1986). The Ecological Approach to Visual Perception. Taylor & Francis.

Goodisman, A. (1991). A Stylus-Based User Interface for Text: Entry and Editing (Tesis doctoral, Massachusetts Institute of Technology). DSpace@MIT. http://hdl.handle.net/1721.1/38858

Greenfield, A. (2010). Everyware: The dawning age of ubiquitous computing. New Riders.

Greengard, S. (2021). The internet of things. MIT press.

Gubbi, J., Buyya, R., Marusic, S., & Palaniswami, M. (2013). Internet of Things (IoT): A vision, architectural elements, and future directions. Future generation computer systems, 29(7), 1645-1660. https://doi.org/10.1016/j.future.2013.01.010

Hansmann, U., Merk, L., Nicklous, M. S., & Stober, T. (2013). Pervasive computing handbook (2.ª ed). Springer Science & Business Media. (Originalmente publicado en 2001)

Hawley, M., Poor, R. D., & Tuteja, M. (1997). Things that think. Personal Technologies, 1, 13-20. https://doi.org/10.1007/BF01317884

Heidegger, M. (1997). Filosofía, ciencia y técnica. Editorial Universitaria de Chile.

Intel Corporation. (2023). Annual Report. Form 10-K. https://www.intc.com/filings-reports/annual-reports/content/0000050863-23-000006/0000050863-23-000006.pdf

Ishii, H., & Ullmer, B. (1997). Tangible bits: towards seamless interfaces between people, bits and atoms. Proceedings of the ACM SIGCHI Conference on Human factors in computing systems, 234-241. https://doi.org/10.1145/258549.258715

International Telecommunication Union. (2005). The internet of things. Executive summary (7.ª ed.). ITU. http://handle.itu.int/11.1002/pub/800eae6f-en

Kittler, F. (2010). Optical media. Polity.

Krumm, J. (Ed.). (2018). Ubiquitous computing fundamentals. CRC Press.

Lakatos, I. (1983). La metodología de los programas de investigación científica. Alianza.

Lauría, E. H. (2000). Ciencia y Tecnología de cara al siglo XXI. Universidad del Salvador. cc

Lave, J., & Wenger, E. (1991). Situated learning: Legitimate peripheral participation. Cambridge University Press.

Mahoney, M. S. (2011). Histories of computing. Harvard University Press.

Manovich, L. (2014). El software toma el mando. Editorial UOC.

Mel, B. W., Omohundro, S. M., Robison, A. D., Skiena, S. S., & Thearling, K. H. (1988). Tablet: personal computer of the year 2000. Communications of the ACM, 31(6), 638-648. https://doi.org/10.1145/62959.62960

Milner, R. (2006). Ubiquitous computing: shall we understand it? The Computer Journal, 49(4), 383-389.

Negroponte, N. (1998). Ser digital. Atlántida.

Norman, D. (1998). La psicología de los objetos cotidianos (Vol. 6). Editorial Nerea. (Originalmente publicado en 1988)

Norman, D. (2000). El ordenador invisible. Paidós.

Parikka, J. (2013). What is media archaeology? John Wiley & Sons.

Polanyi, M. (2002). The tacit dimension. University of Chicago Press. (Originalmente publicado en 1966)

Rheingold, H. (1994, 1 de febrero). PARC is Back! Wired, 2(02). https://www.wired.com/1994/02/parc/

Richterich, A. (2018). The big data agenda: Data ethics and critical data studies. University of Westminster Press.

Rogers, Y. (2006). Moving on from Weiser’s Vision of Calm Computing: Engaging UbiComp Experiences. En P. Dourish, A. Friday (eds), UbiComp 2006: Ubiquitous Computing. UbiComp 2006. Lecture Notes in Computer Science, 4206, 404-421. https://doi.org/10.1007/11853565_24

Ronzani, D. (2009) The battle of concepts: Ubiquitous Computing, pervasive computing

and ambient intelligence in Mass Media. Ubiquitous Computing and Communication

Journal, 4(2), 9-19.

Rossi, L. S. R. (2020). Perspectivas sobre la computación ubicua. PAAKAT, 10(18). https://doi.org/10.32870/Pk.a10n18.410

Ruparelia, N. B. (2016). Cloud computing. MIT Press.

Saha, D., & Mukherjee, A. (2003). Pervasive computing. Computer, 36(3), 25-31. https://doi.org/10.1109/MC.2003.1185214

Sakamura, K. (2003). Ubiquitous computing: Making it a reality (Presentación de paper). ITU Telecom World 2003, Ginebra, Suiza.

Sarma, S., Brock, D., & Ashton, K. (1999). The Networked Physical World. Proposals for engineering the next generation of computing, commerce, and automatic-identification (White Paper MIT-AUTOID-WH001). Auto-ID Center.

Satyanarayanan, M. (2002). A catalyst for mobile and ubiquitous computing. IEEE Pervasive Computing, 1(1), 2-5. https://doi.org/10.1109/MPRV.2002.993138

Sengers, P., Kaye, J., Boehner, K., Fairbank, J., Gay, G., Medynskiy, Y., Wyche, S. (2004). Culturally embedded computing. IEEE Pervasive Computing, 3(1), 14-21. https://doi.org/10.1109/MPRV.2004.1269124

Suchman, L. A. (1985). Plans and situated actions: The problem of human-machine communication (Technical Report ISL-6). Xerox Corporation.

Tedre, M. (2014). The science of computing: shaping a discipline. CRC Press.

Tennenhouse, D. (2000). Proactive computing. Communications of the ACM, 43(5), 43-50. https://doi.org/10.1145/332833.332837

Tinnell, J. (2023). The Philosopher of Palo Alto. Mark Weiser. Chicago Press.

Tolmie, P., Pycock, J., Diggins, T., MacLean, A., & Karsenty, A. (2002). Unremarkable computing. Proceedings of the SIGCHI conference on Human factors in computing systems, 399-406. https://doi.org/10.1145/503376.503448

Want, R., Schilit, B. N., Adams, N. I., Gold, R., Petersen, K., Goldberg, D., Ellis, J., & Weiser, M. (1995). The ParcTab Ubiquitous Computing Experiment. En T. Imielinski, & H. Korth (Eds.), Mobile Computing (pp. 45-102). Springer.

Want, R., Hopper, A., Falcao, V., & Gibbons, J. (1992). The active badge location system. ACM Transactions on Information Systems (TOIS), 10(1), 91-102. https://doi.org/10.1145/128756.128759

Want, R., Pering, T., & Tennenhouse, D. (2003). Comparing autonomic and proactive computing. IBM Systems journal, 42(1), 129-135. https://doi.org/10.1147/sj.421.0129

Wegner, P. (1976). Research paradigms in computer science. Proceedings of the 2nd international Conference on Software Engineering, 322-330. https://dl.acm.org/doi/10.5555/800253.807694

Weiser, M. (1991). The computer for the 21st century. Scientific American, 265(3), 94-105.

Weiser, M. (1992, octubre). Does Ubiquitous Computing Need Interface Agents?. MIT Media Lab Symposium on User Interface Agents. https://web.archive.org/web/20180602090007/http://www.ubiq.com/hypertext/weiser/Agents.ps.

Weiser, M. (1993a). Some Computer Science Problems in Ubiquitous Computing. Communications of the ACM, 36(7), 75-84. https://doi.org/10.1145/159544.159617

Weiser, M. (1993b). Hot Topics: Ubiquitous Computing. Computer, 26(10), 71-72. https://doi.org/10.1109/2.237456

Weiser, M. (1994a). The world is not a desktop. Interactions, 1(1), 7-8. https://doi.org/10.1145/174800.174801

Weiser, M. (1994b, noviembre). Building Invisible Interfaces (Presentación). User Interface, Systems, and Technologies (UIST) Conference, Marina del Rey, California.

Weiser, M. (1995). The Technologist's Responsibilities and Social Change. Computer-Mediated Communication Magazine, 2(4), 17. https://johndecember.com/cmc/mag/1995/apr/last.html

Weiser, M. (1996, 13-15 de marzo). Nomadic Issues in Ubiquitous Computing (Presentación). Nomadic '96: The Nomadic Computing & Communications Conference, San José, California.

Weiser, M. (1998). The future of ubiquitous computing on campus. Communications of the ACM, 41(1), 41-42. https://doi.org/10.1145/268092.268108

Weiser, M. (1999). The spirit of the engineering quest. Technology in Society, 21(4), 355-361. https://doi.org/10.1016/S0160-791X(99)00030-5

Weiser, M. (2001). Whatever happened to the next-generation Internet?. Communications of the ACM, 44(9), 61-69. https://doi.org/10.1145/383694.383708

Weiser, M., & Brown, J. S. (1997). The coming age of calm technology. En Beyond calculation: The next fifty years of computing (pp. 75-85). Springer.

Weiser, M., & Garman. A. (1995). Bleeding Edge Technology–From Lab Coats to Market Caps. Red Herring, (22), 52-58.

Weiser, M., Gold, R., & Brown, J. S. (1999). The origins of ubiquitous computing research at PARC in the late 1980s. IBM Systems Journal, 38(4), 693-696. https://doi.org/10.1147/sj.384.0693

Winner, L. (2000). The voluntary complexity movement. Science as Culture, 9(1), 103-107.

Winograd, T., & Flores, F. (1989). Hacia la comprensión de la informática y la cognición. Editorial Hispano Europea. (Originalmente publicado en 1986).

Wooldridge, M. (2009). An introduction to multiagent systems. John Wiley & Sons.

Wooldridge, M. (2021). A brief history of artificial intelligence. Flatiron Books.

World Economic Forum. (2015). World Economic Forum Annual Meeting 2015. The New Global Context. https://www3.weforum.org/docs/WEF_AM15_Report.pdf

Xerox Palo Alto Research Center. (s.f.). Ubiquitous Computing Page. https://web.archive.org/web/20180602090007/http://www.ubiq.com/hypertext/weiser/UbiHome.html

YRP Ubiquitous Networking Laboratory. (s.f.). Greetings from Director. About YRP UNL https://www2.ubin.jp/en/overview/greeting/

Financiamiento: Instituto de Estudios Sociales – Consejo Nacional de Investigaciones Científicas y Técnicas, Universidad Nacional de Entre Ríos.

Cómo citar: Rossi, L. S. R. (2025). La agenda de la computación ubicua: genealogía de su olvido y fundamentos de su prospectiva. Dixit, 39, e4376. https://doi.org/10.22235/d.v39.4376

Contribución de los autores (Taxonomía CRediT): 1. Conceptualización; 2. Curación de datos; 3. Análisis formal; 4. Adquisición de fondos; 5. Investigación; 6. Metodología; 7. Administración de proyecto; 8. Recursos; 9. Software; 10. Supervisión; 11. Validación; 12. Visualización; 13. Redacción: borrador original; 14. Redacción: revisión y edición.

L. S. R. R. ha contribuido en 1, 2, 3, 4, 5, 6, 7, 8, 10, 11, 12 13, 14.

Editor responsable: L. D. & A. L.